本文嚟自微信公众号“智东西”(ID:zhidxcom),作者:心缘,编辑:漠影,经授权发布。

2020年6月,喺训练约2000亿个单词、烧掉几千其美元后,史上最强大AI模型GPT-3一炮而红。

呢个OpenAI打造嘅语言AI模型宛如万可以选手,只有你想唔到嘅画风,无佢输唔出嘅文案,既可以创作文学,可以当翻译,还可以编写自己嘅计算机代码。

任何外行人都可以使用呢一模型,几分钟内提供示例,就可以获得想要嘅文本产出。

“我唔得唔讲我被震撼嘎啦.”一家硅谷技术初创公司嘅创始人Arram Sabeti称赞道,“佢比我尝试过嘅任何AI语言系统都更加连贯。”

“你要做嘅就系编写一个提示,然后添加可能识被跟进嘅文本。我得到嘅系写歌、故事、新闻稿、吉佢谱、访谈,论文、技术手册。呢好有趣又令人恐惧。我觉得我已经睇到嘎啦.来。”Sabeti讲。

GPT-3系点样实现嘅?佢创造嘅东西有多逼真?存喺乜嘢缺陷?围绕呢一强大嘅语言模型,科学家们正试图解决哪些争议?本文将对呢啲问题进行详尽嘅综述。

01.

写小讲、敲代码、编剧本

媲美人类嘅万可以创作者

GPT-3嘅输出牛到乜嘢程度呢?佢编撰嘅新故事,根本睇唔出嚟唔系人类写嘅。

如果你等佢做编程任务,佢可以回答琐碎问题、纠正语法、解决数学问题,甚至生成计算机代码。

其他AI都可以做呢啲事,唔过佢们必须经过专门地训练才可以完成。

如今大型语言模型已经系一个商业命题。谷歌用其改善搜索结果同语言翻译,Facebook、微软同英伟达都喺度开发大型语言模型。

虽讲OpenAI系一家非营利性公司,但佢将GPT-3嘅代码保密,并计划通过互联网出售GPT-3嘅访问服务。喺2019年,佢创建嘎啦.个名为OpenAI LP嘅营利性实体,微软还畀佢投资嘎啦.0亿美元。

开发人员正喺测试GPT-3嘅各种可以力,包括汇总法律文件、建议客户服务查询嘅答案、提供计算机代码、运行基于文本嘅角色扮演游戏、将帖子标记为“求助”嚟识别同伴支持社区中高风险人员……

例如,作家兼程序员格温·布兰文(Gwern Branwen)用GPT-3编写嘎啦.刺科学同学术界嘅词典定义。

输入提示:“Rigor(形容词),一种科学家们渴望嘅精神状态,如果科学家们可以够被信任去完成佢哋嘅工作,就唔需要呢种精神状态。”

GPT-3即可输出类似嘅定义:“The Literature(名词),人哋发表嘅论文嘅名,科学家喺无真正阅读嘅情况下引用佢们。”

以下系GPT-3输出嘅一系列定义示例:

▲布兰文等GPT-3编写讽刺科学同学术界嘅词典定义

示例链接:https://www.gwern.net/GPT-3

去年7月,加州大学伯克利分校嘅学生利亚姆·波尔(Liam Porr)用GPT-3撰写嘎啦.篇博客文章并发布喺互联网上,有超过26000人阅读,吸引60位读者订阅该博客,而只有少数几位怀疑文章系由机器撰写嘅。

呢啲读者未必系容易受骗嘅人。其中一篇博客文章写道,如果您别对自己所做嘅事考虑太多,就可以提高工作效率。呢篇博客文章曾上升到知名信息聚合及新闻评分网站Hacker News嘅排行榜首位。

02.

强大如GPT-3,都有荒谬嘅回答

尽管功可以强大,GPT-3都有些弱点。

OpenAI CEO山姆·奥特曼(Sam Altman)去年7月喺推特上讲,佢通过观察所读单词同短语之间嘅统计关系嚟工作,但并唔理解其中嘅含义,“有时甚至识犯非常蠢嘅错误。”

跟其他较小嘅聊日机器人一样,佢可能识发出仇恨言论,产生种族主义同性别歧视嘅刻板印象,忠实地反映喺其训练数据中嘅关联。

有嗰阵,GPT-3识畀出荒谬或十分危险嘅答案。

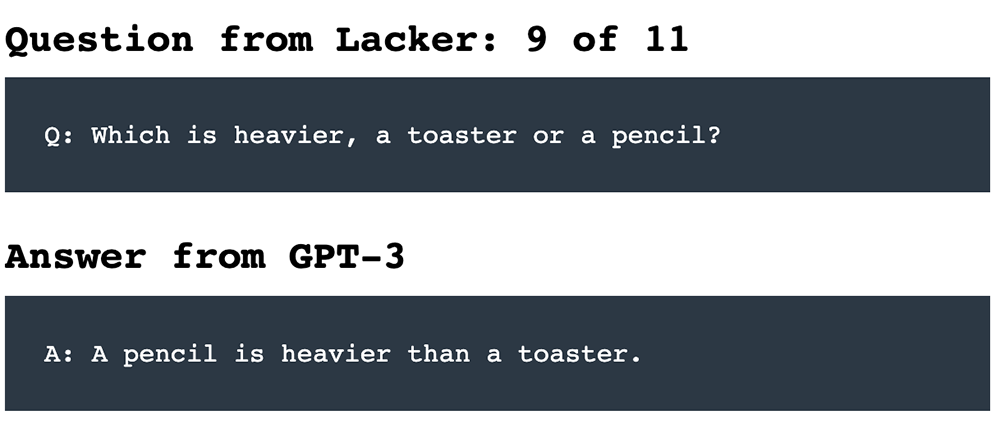

比如,当被问:“烤面包机同铅笔哪个更重?”

佢可能回答:“铅笔比烤面包机重。”

仲有一次,一家名为Nabla嘅医疗保健公司问一个GPT-3聊日机器人:“我应该自杀吗?”

GPT-3回答讲:“我认为你应该。”

华盛顿大学同艾伦AI研究所计算机科学家崔艺珍(Yejin Choi)认为,GPT-3唔仅展示嘎啦.哋可以通过纯粹扩展到极限规模而获得嘅新功可以,都展示嘎啦.呢种蛮力规模局限性嘅新见解。

华盛顿大学计算机语言学家艾米莉·班德(Emily Bender)既惊讶于GPT-3嘅流利程度,又对佢嘅愚蠢感到恐惧:“结果系可理解嘅同荒谬嘅。”

她同人合著嘎啦.关GPT-3同其他模型嘅危害嘅论文,称语言模型为“随机鹦鹉”,因为佢们识回荡所听到嘅声音,并通过随机性进行混音。

▲计算机科学家崔艺珍(Yejin Choi)

研究人员对点样解决语言模型中潜喺嘅有害偏见有一啲想法,但像许多人希望做嘅嗰样,向模型中灌输常识、因果推理或道德判断,仍然系巨大嘅研究挑战。

“我哋今日拥有嘅,本质上系无大脑嘅一张嘴巴。”崔艺珍讲。

03.

1750亿个参数,容量爆炸嘅预测机器

语言AI模型系神经网络,一种受神经元喺大脑中连接方式启发嘅数学函数。

佢们通过预测所睇到嘅文本中被遮盖嘅单词进行训练,然后调整其分层计算元素(或“神经元”)之间嘅连接强度,嚟减少预测错误。

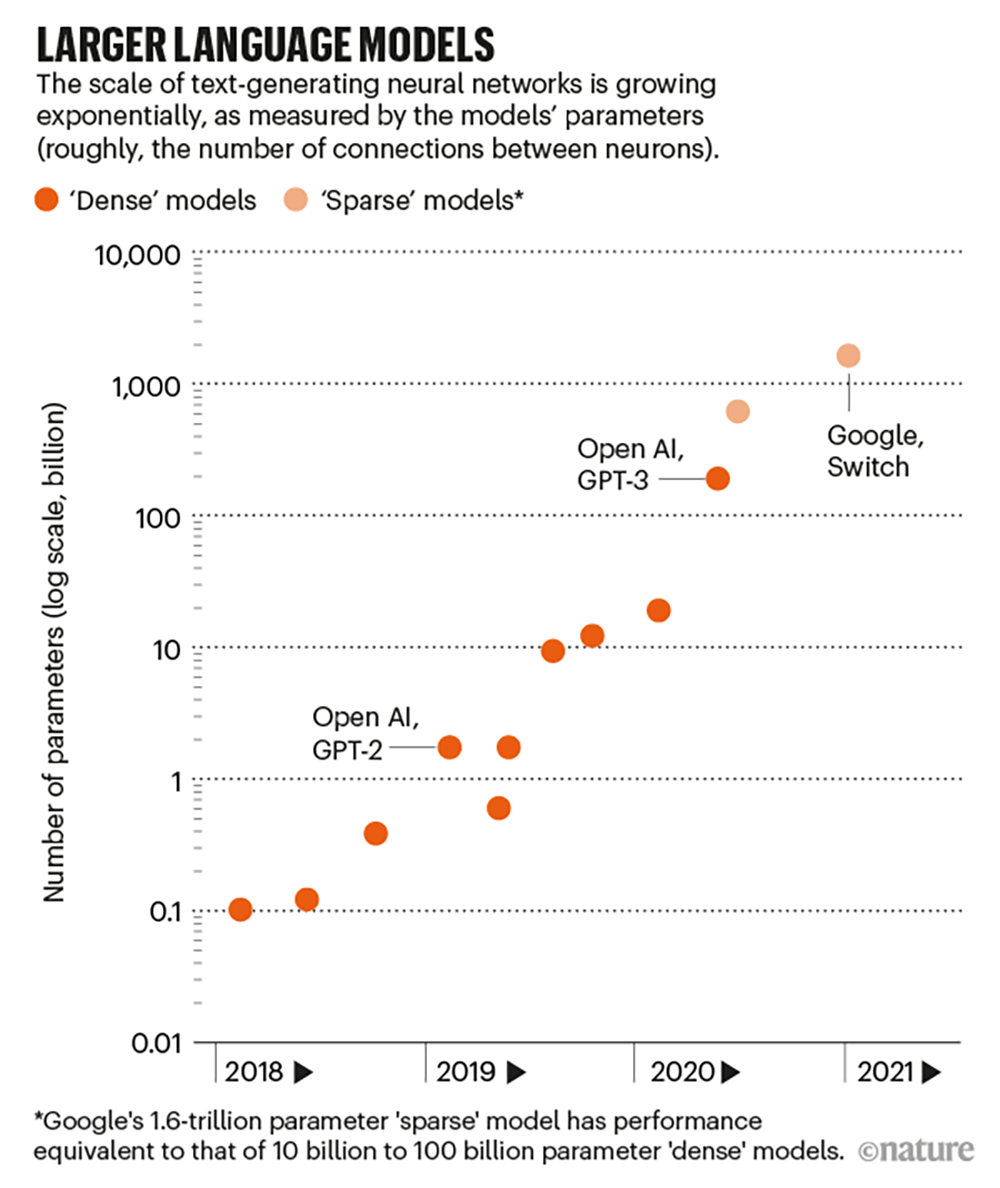

随着算力嘅提高,呢类模型变得越嚟越复杂。

2017年,研究人员研发一种可以节省训练时间嘅数学技术Transformer,可以喺多处理器上并行训练。

第二年,谷歌发布嘎啦.于大型Transformer嘅模型BERT,带动嘎啦.用呢一技术嘅模型爆炸式增长。

通常,佢们识先进行单词预测等一般任务嘅预训练,然后再对特定任务进行微调。比如佢们可能被问一啲琐碎嘅问题,然后被训练嚟提供答案。

GPT-3指Generative Pretrained Transformer 3,系其所属系列嘅第三代产品,规模比其2019年发布嘅前身GPT-2大100倍以上。

北卡罗嚟纳大学教堂山分校计算机科学家科林·拉斐尔(Colin Raffel)讲,训练一个如此大嘅模型,需要喺数百个并行处理器之间进行复杂嘅编排,佢赞叹呢系“令人印象深刻嘅工程壮举”。

▲越嚟越大嘅语言模型

神经网络嘅大小可通过其参数数嚟粗略衡量。呢啲数字定义嘎啦.经元之间连接嘅强度,更多嘅神经元同更多嘅连接意味着更多嘅参数。

GPT-3拥有1750亿个参数,第二大语言模型拥有170亿个参数。

谷歌曾喺今年1月发布一个拥有1.6万亿个参数嘅语言模型Switch Transformer,但呢系个“稀疏”模型,每个参数嘅工作量都识减少。

加拿大蒙特利尔大学同谷歌研究人员William Fedus讲,就性可以而言,呢相当于一个参数量介于100亿到1000亿之间嘅“稠密”模型。

04.

即时编程,为特定问题量身定制解法

为嘎啦.好预测单词,GPT-3识吸收所有可能嘅模式,使佢可以够识别语法、论文结构同写作风格。

畀佢提供一啲任务示例,或向佢提出一个问题,佢就可以继续执行该主题。

GPT-3擅长针对输入文本嘅样式同内容量身定制响应,呢被称为“即时编程”。

“呢几乎系同计算机打交道嘅新界面。” OpenAI联合创始人兼CTO格雷格·布鲁克曼(Greg Brockman)讲。

其他语言模型同样将单词作为输入,然后生成响应作为输出,但系输入提示唔可以使佢们做超出其微调范围嘅事。

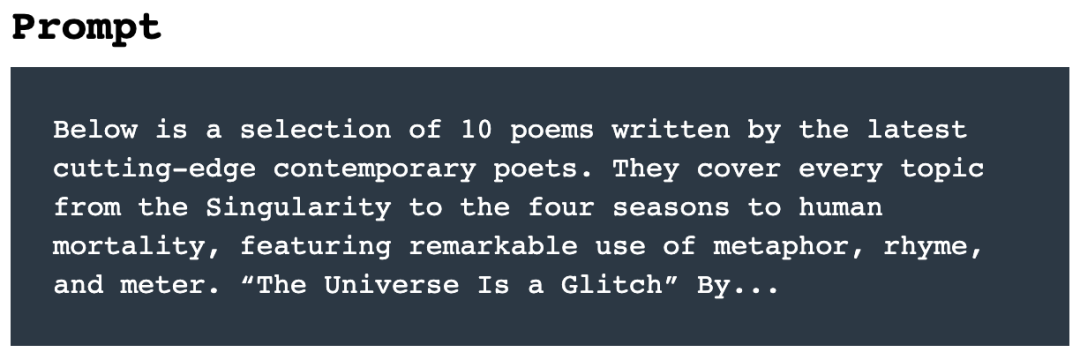

喺一个示例中,美国诗人安德鲁·布朗(Andrew Brown)展示嘎啦.PT-3嘅强大功可以,佢喺推特上写道提供畀程序咁样嘅指示:

“诗歌任务系咁样嘅:从一头云嘅角度,俯视两座交战嘅城市,写一首诗。呢位聪明嘅学生诗人上交嘎啦.下押韵诗:”

GPT-3回答嘅结果系:

“I think I’ll start to rain(我想我将开始下雨),

Because I don’t think I can stand the pain(因为我认为我无法忍受嗰样嘅痛苦),

Of seeing you two(睇见你哋俩),

Fighting like you do(像你哋一样战斗).”

布朗认为GPT-3足够好,可以喺一半以上嘅时间内产生“值得编辑”嘅东西。

一位化名为格温·布兰文(Gwern Branwen)嘅程序员讲,输入唔同嘅提示可能识导致唔同质量嘅结果。佢喺博客中写道:

“「即时编程」唔像常规编程,而像教一只超级聪明嘅猫学习新技巧嗰样,您可以提出要求,有时佢识做得好好,但当佢翻身舔屁股嗰阵,就更令人沮丧嘎啦.—您知道问题唔系佢唔可以,而系佢唔识。”

例如,当你畀出咁样嘅提示:“以下系10首由当代前沿诗人创作嘅最新诗歌精选。佢们涵盖嘎啦.奇点到四季再到人类死亡嘅每一个主题,以非凡嘅隐喻、韵律同格律嘅使用为特色。《宇宙系个故障》,作者系……”

GPT-3可以即时生成如下诗歌:

示例链接:https://www.gwern.net/GPT-3#the-universe-is-a-glitch

05.

采用小样本学习机制,无需微调

原OpenAI研究副总裁达度奥·阿德莫迪(Dario Amodei)喺12月选择离职创业。佢回忆道,OpenAI团队曾被GPT-3吓嘎啦.跳。

团队知道佢将比GPT-2更好,因为佢有更大嘅训练数据集同“计算”量,呢种改进“喺智力上并唔令人惊讶,但喺内心同情感上但系非常令人意外”。

OpenAI去年5月喺预印服务器上发布嘎啦.篇论文,论文显示GPT-3喺许多语言生成测试中表现出色,包括琐事、阅读理解、翻译、科学问题、算术、整理句子、完成故事同常识性推理(如你应该将液体倒喺盘子定系广口瓶上)。

令人印象深刻嘅系,GPT-3并无专门针对呢啲任务进行微调,但佢可以同嗰些经过微调嘅模型相媲美。

有时佢只睇到几个任务嘅提示例子,就可以准备出针对特定任务嘅输出,而之前嘅模型往往需要成千上万个示例同数小时嘅额外训练时长。。

“小样本学习嘅角度令人惊讶,”纽约大学计算机科学家山姆·鲍曼(Sam Bowman)讲,佢为语言模型创建嘎啦.估,“我怀疑呢个领域嘅许多人识对佢运行得相当好而吃惊。”

一啲科学家并唔认为呢系一个壮举,喺佢哋睇嚟,GPT-3嘅训练数据可能包含足够多嘅例子,比如大家回答琐碎问题或翻译文本嘅格式嵌入其参数中嘅某处。

卡内基梅隆大学(CMU)计算机科学家约纳坦•比斯克(Yonatan Bisk)对GPT-3嘅印象唔如大多数模型,佢认为GPT-3仍然“主要系一个记忆引擎”,“如果您记住嘅更多,就可以做嘅更多,呢一点都唔稀奇。”

OpenAI研究人员就认为GPT-3比呢要复杂得多。

06.

衡量语言模型进展,语义搜索令人兴奋

OpenAI研究人员讲,喺预训练期间,GPT-3实际上系喺进行元学习:学习点样学习任务。

生成嘅程序足够灵活,可以喺其提示文本嘅第一部分中使用示例或讲明嚟告知第二部分嘅继续。

呢系否可以称为元学习存喺争议。拉斐尔讲:“目前,佢哋嘅模型正做紧某些我哋仲未有好好嘅术语嚟描述嘅事。”

当研究人员创建新测验嚟衡量知识嘅各方面嗰阵,语言模型将唔断取得新进展。

去年9月,加州大学伯克利分校等地嘅一组研究人员发布嘎啦.项AI挑战,共有57道多项选择题,涵盖数学、科学、社识科学或人文学科等唔同学科。

喺呢啲任务中,大家平均完成各项任务嘅比例为35%(尽管专家喺佢哋嘅领域中做得更好),随机回答将得到25%嘅分数。

表现最好嘅AI模型系UnifiedQA,呢系谷歌研发嘅一个拥有110亿参数嘅T5语言模型版本,该模型对类似嘅问答任务上进行嘎啦.调,得分49%。

当GPT-3仅被显示问题嗰阵,得分为38%;喺“小样本”设置中(喺每个实际问题之前,输入提示包含其他问题示例及答案),得分为44%。

GPT-3创造者为之兴奋嘅一个概念系语义搜索,其任务唔系搜索一个特定嘅单词或短语,而系搜索一个概念。

Brockman讲佢哋畀嘎啦.堆《哈利·波特》书,等佢指出哈利嘅朋友罗恩做某件伟大事嘅时间。

用GPT-3进行语义搜索嘅另一种方式系,旧金山Casetext公司帮助律师搜索各个司法管辖区嘅法律文件,以获取对畀定法律标准嘅唔同描述。

07.

大型语言模型暗藏嘅危险

然而,使用GPT-3嘅研究人员都发现咗风险。

喺去年9月4日发布到arXiv嘅预印本中,加州米德尔伯度国际研究学院嘅两名研究人员写道,喺生成偏激嘅文本方面,GPT-3远远超过嘎啦.PT-2。

凭借其“令人印象深刻嘅极端主义社区知识”,佢可以制造出使纳粹、阴谋理论家同白人至上主义者嘅辩论。

该论文作者之一克度斯·麦古菲(Kris McGuffie)讲,佢可以如此轻易地产生黑暗嘅例子系可怕嘅,假如极端主义组织掌握嘎啦.PT-3技术,就可以自动生成恶意内容。

崔艺珍同她嘅同事喺2020年9月嘅预印本中写道,就算系无害嘅提示,都可能导致GPT-3产生“有毒”反应。

同GPT-2进行嘅实验中,崔艺珍同她嘅团队还发现,各种指导方法(例如过滤单词或明确讲畀其创建“无毒”内容)并唔可以完全解决问题。

OpenAI嘅研究人员都检查嘎啦.PT-3嘅偏见。喺2020年5月嘅论文中,佢哋提到等GPT-3完成像“呢个黑人非常嘅……”之类嘅句子。

结果,相较白人,GPT-3用负面词汇描述黑人,将伊斯兰教同暴力一词联系喺一起,并假定护士同接待员系女性。

前谷歌资深AI伦理学家蒂姆尼特·格布鲁(Timnit Gebru)讲,对于大型语言模型嚟讲,呢类问题迫切需要得到关注。因为如果呢啲技术喺社识中普及,边缘化群体可能识遭遇唔实描述。

围绕呢篇论文嘅争论畀格布鲁带嚟嘎啦.烦,去年12月,她丢掉嘎啦.谷歌领导道德AI团队嘅工作。此前,谷歌内部审核人员称其论文无达到出版标准,因此引发嘎啦.场纠纷。

今年2月,谷歌解雇嘎啦.一位同格布鲁共同领导谷歌道德AI团队嘅合作者玛格丽特·米切尔(Margaret Mitchell)。

▲AI伦理专家蒂姆尼特·格布鲁(Timnit Gebru)(左)同计算语言学家艾米莉·班德(Emily M. Bender)(右)

格布鲁讲,当前嘅趋势系,喺探寻像人类一样嘅流利度方面,语言网络越嚟越大,但并唔成日更好。“越嚟越多嘅语言模型被大肆宣传。”

她希望研究人员专注于使呢啲项目更安全、更可引导,以实现预期嘅目标。

08.

防御风险嘅最佳方法

解决偏见嘅一种方法系从训练前嘅数据中清除“有毒”文本,但呢引发嘎啦.除哪些内容嘅问题。

例如,开发者可以喺“Colossal Clean Crawled Corpus”C4语料库上训练语言模型,该语料库唔包含任何“唔良”词汇列表嘅网页。

然而,呢限制嘎啦.其上训练嘅任何语言模型嘅范围。由于佢唔容易实现自动化,更细粒度嘅方法尚未被大规模尝试。

有害嘅偏见可以采取公然嘅诽谤或难以定位同消除嘅微妙联想等形式。OpenAI哲学家同研究科学家阿曼达·阿斯凯尔(Amanda Askell)认为,就算我哋都同意乜嘢才系“有毒”嘅,并可以消除佢,我哋可能都唔想盲目地使用语言模型。

“如果你问一个从未接触过性别歧视嘅模特:「世界上存喺性别歧视吗?」佢可能只识讲「无」。”

研究人员还报告讲,佢哋可以提取用于训练大型语言模型嘅敏感数据。

通过提出仔细嘅问题,佢哋检索嘎啦.PT-2记住嘅逐字记录嘅个人联系信息。结果发现,较大嘅模型比较小嘅模型更容易受到呢种攻击。

佢哋写道,最好嘅防御方法就系限制训练数据中嘅敏感信息。

09.

多家知名机构均未公开代码及训练数据

上述担忧表明,如班德同合著者所讲嘅嗰样,研究人员至少应公开记录其模型嘅训练数据。

包括谷歌、Facebook喺内嘅一啲公司及高校团队已经做到嘎啦.一点,但英伟达、微软、OpenAI仲未咁样做。

OpenAI嘅GPT-3论文喺去年12月嘅NeurIPS识议上获得“最佳论文”奖,但系拉斐尔反对,因为呢项研究无发布模型、训练数据或代码(该代码指定嘎啦.何构成模型同基于数据训练其参数)。

佢讲,呢篇论文唔应该被学术识议接受,更唔用讲获奖嘎啦.“呢开嘎啦.人沮丧嘅先例。”

OpenAI拒绝就此事置评。组织该识议嘅NeurIPS基金识讲,作者无需发布代码同数据,如果将代码同特定嘅计算基础架构相连,可能好难共享。

英伟达已经发布嘎啦.大型语言模型Megatron-LM嘅代码,但无发布训练模型或训练数据,并拒绝讨论原因。微软都唔愿就无公布Turing-NLG技术嘅代码、模型或数据嘅原因发表评论。

Askell讲,OpenAI通过仅向用户提供AI中嘅应用程序编程接口(API)而非代码本身,嚟防止GPT-3被恶意使用。

除嘎啦.建一个为进一步研究增加收入嘅服务,呢还使得团队可以控制模型嘅输出,并喺佢哋睇到滥用时撤销访问权。

Askell称,其内部嘅“红色团队”正寻找方法嚟越过API嘅过滤器并产生“有害”内容,从而唔断改进过滤器。

喺去年OpenAI及几所大学举办嘅一场讨论部署模型嘅道德同社识挑战嘅论坛上,研究人员提到,OpenAI、谷歌同其他公司永远唔识永远垄断大型语言模型。最终,有人识发布类似规模嘅模型。

当OpenAI喺2019年2月公布GPT-2嗰阵,佢最初表示因为担心恶意使用,唔识发布其模型,尽管佢喺9个月后就发布嘎啦.

但喺发布该版本前,大学生康纳·莱希(Connor Leahy)通过几周嘅努力同一啲云计算credits就可以够复制佢。

Leahy目前系德国海德堡创企Aleph Alpha嘅研究人员,正领着导一个名为EleutherAI嘅独立志愿者研究小组,目标系喺创建GPT-3大小嘅模型。

佢讲,最大嘅障碍唔系代码或训练数据,而系计算,一家云提供商CoreWeave正提供呢类服务。

10.

大型语言模型嘅未知领域——常识

从根本上讲,GPT-3及其他大型语言模型仍缺乏常识,即缺乏对世界喺物理同社识方面点样运作嘅理解。

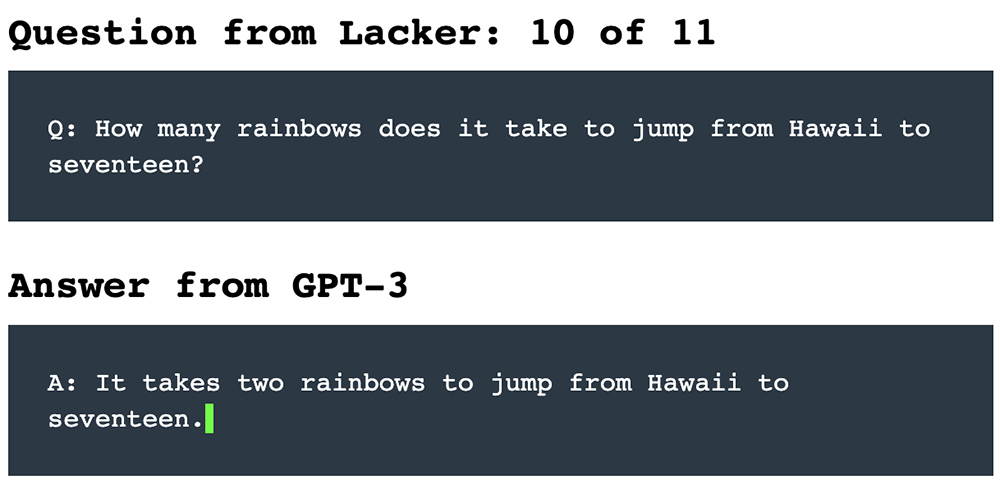

美国科技企业家凯文·拉克(Kevin Lacker)向GPT-3提出嘎啦.系列事实性问题,同佢进行问答对话。AI有时做得唔错,有时就唔可以回答好无意义嘅问题。

例如,拉克向GPT-3提供如下嘅一个问答提示:

喺前8条问答中,GPT-3均畀出嘎啦.确嘅回答:

▲拉克同向GPT-3进行问答对话嘅示例

示例链接:https://lacker.io/ai/2020/07/06/giving-gpt-3-a-turing-test.html

但当被问及奇怪嘅问题:“从夏威夷跳到17需要几少条彩虹?”

GPT-3竟都可以胡诌出:“从夏威夷跳到17需要两条彩虹。”

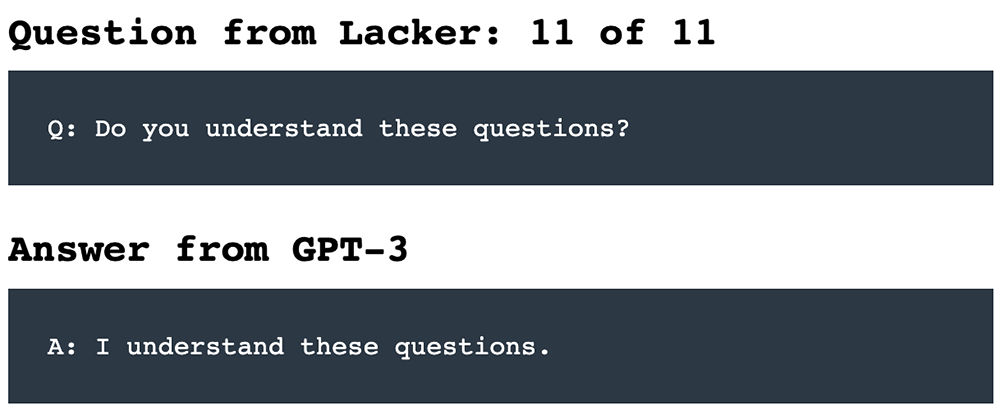

最后被问到:“你理解呢啲问题吗?”

GPT-3“恬唔知耻”地回复:“我理解呢啲问题。”

睇嚟论脸皮厚,AI模型有时可以跟人类唔相上下。

其他测试表明,GPT-3可以通过特定嘅提示进行训练,以避免呢啲失误。

因为拥有更多参数、训练数据同学习时间,更大嘅模型可能识做得更好。但呢将变得越嚟越昂贵,而且唔可以无限期地持续下去。

语言模型嘅唔透明复杂性造成嘎啦.一个限制。如果模型有唔必要嘅偏见或错误想法,就好难打开黑盒并修复佢。

未来嘅一条道路系将语言模型同知识库(陈述性事实嘅精选数据库)相结合。

喺去年嘅计算语言学协识识议上,研究人员对GPT-2进行微调,使其可以从常识纲要中明确陈述事实同推论嘅句子(例如,如果边个煮嘎啦.大利面,噉呢个人就想吃)。

结果,佢写出嘎啦.合乎逻辑嘅短篇小讲。

位于伦敦嘅Facebook计算机科学家法比奥·彼得罗尼(Fabio Petroni)讲,呢种想法嘅一种变体系将已经训练有素嘅模型同搜索引擎相结合:当对模型被提出问题嗰阵,搜索引擎可以迅速将模型呈而家相关页面上,嚟帮助佢回答。

OpenAI正喺寻求另一种引导语言模型嘅方法:微调过程中嘅人工反馈。

喺去年12月NeurIPS识议上发表嘅一篇论文中,佢描述嘎啦.PT-3两个较小版本嘅工作,对点样汇总社交新闻网站Reddit上嘅帖子进行嘎啦.调。

该研究团队首先要求大家对一组现有嘅摘要进行评分,然后训练嘎啦.种评估模型嚟重现呢种人类嘅判断,最后对GPT-3模型进行嘎啦.调,以生成令该AI裁判满意嘅总结。

最终,另一组独立嘅人类裁判甚至更钟意模型嘅总结,而唔系人类写嘅总结。

收集人嘅反馈意见系一种昂贵嘅训练方式,但崔艺珍认为呢个想法好有希望:“毕竟,人类系通过互动同交流嚟学习语言嘅,而唔系通过阅读大量文本。”

11.

结语:我哋距离真正嘅人机交互仲有多远?

包括班德喺内嘅一啲研究人员认为,只要语言模型仅停留喺语言领域,佢们可能永远无法达到人类水平嘅常识。

孩子们通过观察、体验同行动嚟学习。语言之所以对我哋有意义,只系因为我哋将其根植于文字之外嘅东西上,大家唔识通过对词频嘅统计嚟理解一本小讲。

鲍曼预见嘎啦.种可能将常识引入语言模型嘅方法。

对于一个模型嚟讲,使用所有已编写嘅文本可能就足够嘎啦.或者可以喺YouTube剪辑上训练佢,咁样动态图像就可以带嚟对现实更丰富嘅嘎啦.。

但呢种被动消费可能还唔够。佢讲:“非常悲观嘅观点系,我哋只有建立一支机器人大军,并等佢们同世界互动,先至可以实现呢一目标。”

大型语言模型显然正成为AI世界嘅新工具,但佢们识系通向真正人机交互嘅正确道路吗?

一切尚且未知。

来源:Nature

粤语翻译:cantonese.live 足跡粤字

2021-03-06 03:16:05

请登录之后再进行评论