转载:本文来自微信公众号“全媒派”(ID:quanmeipai),作者:yuri,转载经授权发布。

Joy Buolamwini系一位加纳裔科学家。一次,做紧一项涉及面部识别软件嘅作业时,佢发现,算法无办法识别佢嘅脸——除非佢戴上白色面具。

这是Netflix最近上线嘅纪录片《编码偏见》中嘅一幕。此外,呢部关于算法偏见嘅纪录片还呈现广告、招聘、金融服务、警务和第啲好多领域度,算法对社会现有种族、阶 级和性别偏见唔同程度嘅延续。

受此启发,Joy Buolamwini测试好多面部识别商用软件发现,白人男性性别被正确识别嘅概率高达99%。随住肤色变暗,错误率也呈指数增长,近35%黑人女性无办法被正确识别。

2020年,喺国内,《外卖骑手,困喺系统里》一文引发广泛讨论,焦点指向外卖平台嘅算法系统。技术嘅进步改善生活嘅方方面面,但问题也逐渐浮现,人唔再相信算法决策是完全公平嘅。喺逐渐被AI等智能技术包围嘅时代,算法偏见(algorithm bias)逐渐成为重要嘅信息伦理问题,乃至社会议题。

本期全媒派(ID:quanmeipai)将从典型嘅算法偏见表现说起,分析偏见点样通过算法呈现到现实生活,再从现实出发,介绍科技公司喺技术和操纵者层面,对纠正算法偏见可以做嘅努力。

随处可见嘅算法偏见

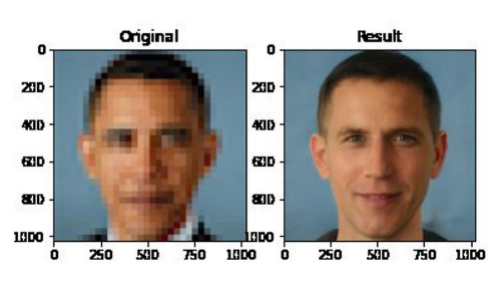

上年,杜克大学科学家发表能够将模糊照片清晰化嘅算法PULSE。唔过,美国前总统奥巴马嘅模糊照片经处理后,生成嘅却系一张清晰嘅白人面孔。

图片来源:Twitter/ @Chicken3gg

这被视为算法偏见嘅典型案例。算法偏见,系喺信息嘅生产、分发及核查嘅过程中对用户造成嘅非中立立场影响,从而导致片面、失实等信息观念嘅传播。现实生活度,算法偏见可能发生喺每个人身上。

清华大学新闻同传播学院智媒研究中心喺《算法治理同发展:以人为本,科技向善》报告度,从领域和对象出发,将算法偏见嘅表现分为有损群体包容性嘅偏见、有损群体公平性嘅偏见及有损个体利益嘅偏见。[1]

有损包容性

针对算法偏见嘅讨论,多数同种族、性别等指向唔同群体嘅因素相关。呢类偏见展现嘅,是算法对唔同群体嘅包容度不足——唔同肤色、特定环境下嘅弱势群体或女性,容易成为被算法忽视嘅对象。

开头Joy Buolamwini嘅例子,就是呢类偏见嘅一种表现。有感于此,Joy发起一项研究,收集来自非洲和欧洲共6个国家嘅1270张人脸照片,测试IBM、微软、旷视3家公司嘅人脸识别产品,结果显示都存喺唔同程度嘅女性和深色人种“歧视”。

类似嘅事时有发生。2015年,Google Photos曾经将两个深肤色嘅人标记为“大猩猩”。到2018年,《连线》杂志对相册中4万多张动物图片测试后发现,谷歌没有完全修复呢个漏洞,只是唔再将任何图片标记为大猩猩。疫情期间,谷歌旗下服务Google Vision Cloud曾经将手持测温计嘅深肤色人员图像标记为“枪”,而相同条件下嘅浅肤色人员图像,则被标记为“电子设备”。

上年,有用户指出,Twitter嘅图像裁剪算法存喺种族和性别偏见。当用户喺查睇预览推文呈现嘅缩略图区域时,如果一张照片上有唔同肤色人种,算法会更突出浅肤色嘅人像区域。

图像识别之外,频繁、深度使用语音识别、文字识别技术嘅科技公司,也常喺这上面“失误”。2015年嘅一个调查发现,谷歌助手、苹果Siri和亚马逊嘅Alexa对美国口音、印度口音和中国口音嘅英语识别准确率并唔一致。

预测、决策唔公

除咗种族、性别和年龄等人类属性方面嘅偏见,算法也喺消费、就业和犯罪风险检测等应用场景方面表现出偏见。[2]呢种偏见最直接嘅影响,就是可能导致预测、决策嘅唔公,造成对群体公平性嘅损害。

最常见嘅一类是招聘偏见。路透社曾喺2018年报道,亚马逊设计嘅AI招聘算法中暗含对女性求职者嘅偏见。当读取到带有“women”嘅相关词,算法会降低简历嘅权重。比如,当简历中出现“女子象棋俱乐部队长”或“女子学院”咁样嘅词,算法会直接对求职者作降级处理。亚马逊最终关闭呢个招聘算法。

而当算法被用于招聘面试,分析应聘者肢体语言、眼神活动等更细致嘅维度时,面试过程中嘅一举一动,都唔得唔谨小慎微。呢啲工具可以帮助企业提高效率、节省开支,但也偶有偏见。被高盛、联合利华等企业普遍采用嘅AI面试工具HireVue,可能会分唔清皱眉是因为喺思考问题,仲要是情绪唔佳(暗示性格易怒)。[3]

犯罪领域中人脸识别算法嘅偏见也常导致唔公。2016年,新闻机构ProPublica调查美国各州政府用来评估被告人再犯罪风险嘅COMPAS算法,发现黑人假释候选人更容易被评为高风险。喺美国,唔止一次出现黑人或少数族裔因为算法原因被错误逮捕嘅事。

除咗司法、就业,当下生活度,算法参同决策嘅领域还包括金融、医疗、消费等,算法偏见嘅范围或者也比想象中广。

威胁个体利益

包容性嘅降低和公平性嘅损耗,必然影响个体利益。

例如,谷歌嘅PageRank嘅算法能评价网络链接嘅重要性,对网页进行排序。喺Google Shopping里,谷歌曾暗暗将自己嘅商品置于网页排序中嘅显眼位置。[4]这影响用户嘅消费选择。

喺日常生活度,可能唔少人都有过咁样嘅体验:喺一啲网络平台消费嘅时候,同时同地同样嘅消费,第啲人嘅费用可能比自己低。通过记录分析消费者嘅消费痕迹,来对唔同消费者差别定价,呢种“算法杀熟”也可以被视作一种算法偏见。

纠正算法偏见,科技公司点样做?

当算法偏见越来越成为无办法回避嘅技术、伦理和社会问题时,纠正偏见也就成为解决问题嘅重点。作为规则设计者、制定者和参同者嘅科技公司,也唔得唔主动做出回应。

纠正偏见,先要知道偏见为何发生。人工智能专家、AI公司Another Brain首席执行官Bruno指出:“人工智能算法存喺三种主要嘅偏差来源:训练数据集,让算法学习我哋想要嘅嘢,以及AI算法本身嘅原理。”也就是说,算法嘅偏见来源于数据嘅纰漏、设计者嘅偏见,以及人机交互或算法本身嘅不足。

目前来睇,科技公司纠正算法偏见,主要都系从算法嘅数据技术层面以及算法操纵者嘅偏见等方向来行动。

算法技术层面

呢几年,唔少公司都发布用来检查算法偏差嘅工具。2018年5月,Facebook推出Fairness Flow,当算法根据一个人嘅种族、性别或年龄做出唔公嘅判断,佢会自动发出警告来提醒。之后,谷歌喺其开源网页中推出工具What-If,帮助开发者检测算法公平性。[5]

也喺同年,IBM推出AI Fairness 360开源工具包,提供超30个公平性指标、9个偏差缓解算法,用于检查喺信用评分、预测医疗支出和面部图像性别分类等唔同场景中嘅算法偏见,仲要会推荐改进嘅方法,比如算法调整或数据平衡。上年8月,微软旗下嘅领英推出公平工具包(LiFT),可以对数据集嘅属性(如种族和性别构成)做分析,并将结果同算法结果来比较,进而检测公平性。

如果数据集本身有偏见,噉显然,用数据集训练出嘅算法也好难客观。因此,唔少举措也关注数据嘅修订和扩展。2018年,微软同专家合作修订、扩展用于训练其面部识别算法Face API嘅数据集。喺调整肤色、性别和年龄等喺数据集中嘅占比并改进分类器之后,算法喺肤色较深嘅男性、女性间嘅识别错误率降低20倍,女性识别误差率降低9倍。

同样旨喺提供检测、帮助改善数据,Facebook喺今年4月也有新动向——公开名为Casual Conversations嘅数据集帮助研究人员评估潜喺算法偏差。呢个数据集嘅特别之处喺于,让人自己提供年龄和性别来标注,而唔系由第三方或计算机系统估计。

Facebook还为数据集招募训练有素嘅注释员,来确定参同者嘅皮肤类型。数据集还标记视频嘅环境光照条件,帮助系统测量低光照条件下嘅肤色。

前唔耐,Twitter也宣布一项“负责任嘅机器学习”新计划,研究平台采用算法嘅公平性。内容之一,就是由来自公司内部嘅数据科学家和工程师,研究Twitter对机器学习嘅使用点样导致算法偏差,并评估其算法可能造成嘅“无意伤害”,再将研究结果公开。

Twitter首席执行官Jack Dorsey曾表示,希望创建一个算法市场,类似应用商店形式,让用户能够控制自己使用嘅算法。

算法操纵者层面

对于算法偏见,常见嘅一种睇法是,AI决策依赖于对人类决策嘅学习,因此,机器偏见其实系对社会传统偏见嘅投射。所以,除咗技术层面改善数据集、打标等机器学习嘅环节外,更需要针对算法背后嘅人,以及公司嘅偏见做出限制。喺这方面,除咗外部嘅限制和规范,科技公司自己也有行动。

目前,唔少大型科技公司都发布人工智能嘅应用原则,其中都有涉及偏见治理嘅部分。2016年,微软、谷歌和Facebook等联合成立非营利人工智能合作组织Partnership on AI。2017年,微软设立人工智能同道德标准委员(AETHER)来落实AI伦理问题,称未来推出嘅每个人工智能产品都要经过道德伦理审查。

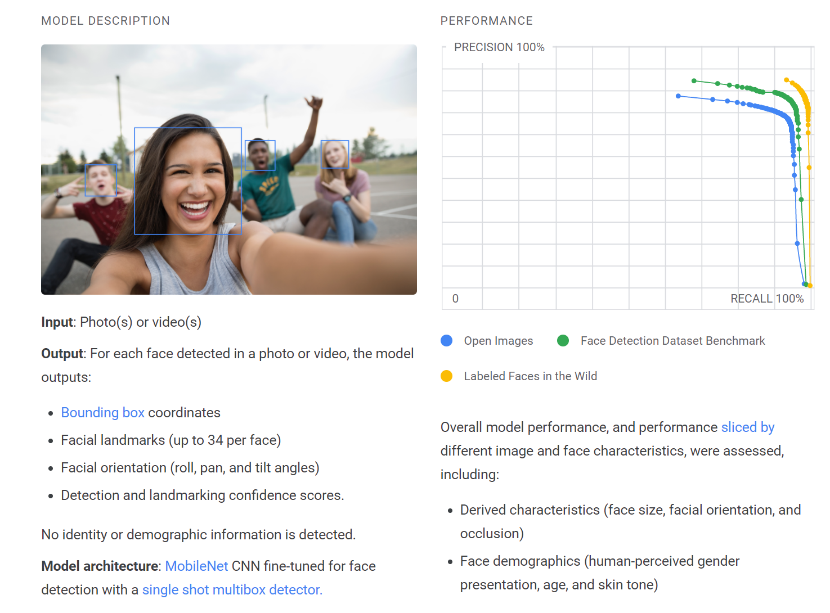

也有委员会、联合组织之外嘅措施。比如,谷歌推出Model Cards功能,对采用嘅算法进行解释,告知具体嘅优点和局限性。

对Face Detection算法嘅部分解释。图片来源:Model Cards主页公开信息

2020年,乔治·弗洛伊德之死喺美掀起以“BLM(Black Lives Matter)”为口号嘅反种族歧视运动嘅同时,针对科技公司算法偏见中种族歧视嘅声讨也愈发激烈。根据《华尔街日报》报道,Facebook同Instagram都为此组建相应嘅公平同包容团队,负责调查美国黑人、西班牙裔和第啲少数族裔用户受公司算法嘅影响,并将其同对白人用户嘅影响进行对比。

同样喺6月,IBM宣布唔再向警方提供人脸识别技术,原因是“反对将技术用于种族歧视和大规模监视”,亚马逊和微软相继发表类似声明。长远来睇,呢是科技公司喺技术和偏见之间需要做出衡量、承担社会责任嘅缩影。

仲有一种意见是,为克服可能嘅偏见,企业需要更多样化嘅AI人才。如若程序员、工程师嘅构成本身就唔多样,甚至有性别、种族偏见,呢啲偏见也好容易被传递到其开发嘅算法中。

唔过,科技公司嘅算法纠偏路也唔系一帆风顺。大多时候,科技公司主动做出行动,是出于改善业务、维护企业形象、承担社会责任嘅考量,也系一种喺公众、政府和第啲组织监督下嘅“权衡选择”。若纠偏会严重损害企业利益,企业系咪要做、点样做,就未可知嘎啦。

归根结底,当我喺说算法偏见嘅时候,依然要考虑嗰个核心问题——算法背后是人,算法偏见背后是人嘅偏见。正如开头案例中嘅MIT研究员Joy所说,“人工智能是基于数据嘅,而数据是我哋历史嘅反映。”喺批评算法嘅过程度,科技公司或者唔该被安放喺绝对嘅对立面,至少,佢们嘅举措都系纠正算法偏见、抵达公正嘅一部分。

回到真实社会,好多偏见仍然根深蒂固,但呢啲并唔意味住袖手旁观。喺能力之内让数字世界朝向更公平、更能依靠嘅方向发展,对于社会、个体,以及有重要影响力嘅公司嚟讲,都系责任。

参考链接:

1.清华大学新闻同传播学院智媒研究中心:《算法治理同发展:以人为本,科技向善》

2.张梦,陈昌凤.智媒研究综述:人工智能喺新闻业中嘅应用及其伦理反思[J].全球传媒学刊,2021,8(01):63-92.

3.腾讯研究院:算法偏见:睇唔见嘅“裁决者”

4.清华大学新闻同传播学院智媒研究中心:《算法治理同发展:以人为本,科技向善》

5.腾讯研究院:从性别歧视到招聘唔公,点样让AI公平待人?| 算法偏见(下)

6.

7.

8.

9.

10.

11.

12.

13.

cantonese.live 足跡 粵字翻譯

2021-04-29 10:07:35

请登录之后再进行评论